生成式 AI 的快速发展,将强大的公开可用的大型语言模型LLMs)(如 DeepSeek-R1) 带到了创新的前沿。DeepSeek-R1模型现在可以通过 Amazon Bedrock Marketplace 和 Amazon SageMaker JumpStart 访问,而提炼优化的变体可以通过 Amazon Bedrock 自定义模型导入获得。

根据 DeepSeek AI 的说法,这些模型在推理、编码和自然语言理解方面提供了强大的能力。但是与所有模型一样,它们在生产环境中的部署需要仔细考虑数据隐私要求、适当管理输出中的偏差,以及需要强大的监控和控制机制。而亚马逊云科技恰好非常擅长者方面的处理,如您有需要可以访问亚马逊云科技了解了解。

采用 DeepSeek-R1 等开源、开放权重模型的企业需要考虑解决几个关键问题:

- 以

OWASP LLM Top 10和MITRE Atlas等资源为指导,加强安全措施以防止潜在的滥用。 - 确保保护敏感信息。

- 培养负责任的内容生成实践。

- 遵守相关行业法规。

这些问题在医疗保健、金融和政府服务等受到高度监管的行业中尤为严重,在这些行业中,数据隐私和内容准确性至关重要。

该篇文章提供了使用 Amazon Bedrock Guardrails 为 DeepSeek-R1 和其他开放模型实施强大安全保护的保护措施。我们将探讨:

- 如何使用

Amazon Bedrock提供的安全功能来保护您的数据和应用程序。 - 实际实施防护机制,防止及时攻击并过滤有害内容。

- 实施强大的深度防御策略。

通过阅读本指南,您将学习如何使用 DeepSeek 模型的高级功能,同时保持强大的安全控制并促进合乎道德的 AI 实践。无论是开发面向客户的生成式 AI 应用程序还是内部工具,这些实施模式都将帮助您满足对安全和负责任的 AI 的要求。通过遵循这种循序渐进的方法,组织可以根据 AI 安全和安保的最佳实践部署 DeepSeek-R1 等开放权重 LLMs。

Amazon Bedrock 上的 DeepSeek 模型和部署

DeepSeek AI 发布了六个源自 DeepSeek-R1 的密集模型,这些模型基于 Llama 和 Qwen 架构构建,他们制作了开放式模型。这些模型现在可以通过 Amazon Web Services 生成式 AI 解决方案访问:DeepSeek-R1 可通过 Amazon Bedrock Marketplace 和 SageMaker Jumpstart 获得,而基于 Llama 的蒸馏版本可以通过 Amazon Bedrock 自定义模型导入实现。

Amazon Bedrock 提供全面的安全功能 ,以帮助安全地托管和运行开源和开放权重模型,同时保持数据隐私和法规合规性。主要功能包括静态和传输中的数据加密、精细访问控制、安全连接选项和各种合规性认证。此外,Amazon Bedrock 还为内容筛选和敏感信息保护提供护栏,以支持负责任的 AI` 使用。Amazon通过广泛的平台范围的安全性和合规性措施来增强这些功能:

- 使用

Amazon Key Management Service对静态和传输中的数据进行加密 - 通过

Amazon Identity and Access Management进行访问管理 - 通过

Amazon Virtual Private Cloud部署、VPC终端节点和用于TLS检查和严格策略规则的 - 用于 Amazon 账户级监管的服务控制策略 (SCP) - 用于访问限制的安全组和网络访问控制列表 (NACL)

- 合规性认证 ,包括

HIPAA、SOC、ISO和GDPR - 通过

Amazon CloudWatch和Amazon CloudTrail进行监控和日志记录

在部署到生产环境时,组织应根据其特定的合规性和安全需求自定义这些安全设置。作为其安全流程的一部分,Amazon对所有模型容器进行漏洞扫描,并且只接受 Safetensors 格式的模型,以帮助防止不安全的代码执行。

如果您想安全无顾虑的部署DeepSeek-R1模型可以访问:亚马逊云科技。

Amazon Bedrock Guardrails

Amazon Bedrock Guardrails 提供可配置的保护措施,以帮助安全地大规模构建生成式 AI 应用程序。Amazon Bedrock Guardrails 还可以与其他 Amazon Bedrock 工具(包括 Amazon Bedrock 代理和 Amazon Bedrock 知识库 )集成,以构建更安全、更可靠的生成式 AI 应用程序,并符合负责任的 AI 策略。

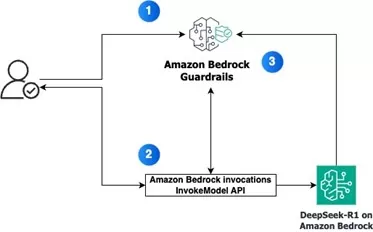

核心功能Amazon Bedrock Guardrails可以通过两种方式使用。首先,它可以直接与 InvokeModel 和 Converse API 调用集成,在推理过程中,护栏将应用于输入提示和模型输出。此方法适用于通过 Amazon Bedrock Marketplace 和 Amazon Bedrock 自定义模型导入托管在 Amazon Bedrock上的模型。或者,ApplyGuardrail API 提供了一种更灵活的方法,允许在不调用模型的情况下独立评估内容 。第二种方法可用于评估应用程序各个阶段的输入或输出,以及使用 Amazon Bedrock 外部的自定义或第三方模型。这两种方法都使开发人员能够实施针对其使用案例定制的保护措施,并与负责任的 AI 策略保持一致,从而确保在生成式 AI 应用程序中进行安全合规的交互。

护栏策略Amazon Bedrock Guardrails 提供以下可配置的护栏策略,以帮助安全地大规模构建生成式 AI 应用程序:

- 内容过滤器:可调节有害内容的过滤强度,预定义类别:仇恨、侮辱、色情内容、暴力、不当行为和及时攻击,包括文本和图像的多模式内容。

- 主题筛选器:限制特定主题的功能,防止在查询和响应中出现未经授权的主题。

- 单词过滤器:阻止特定单词、短语和亵渎,针对冒犯性语言或竞争对手引用的自定义过滤器。

- 敏感信息筛选器:个人身份信息 (PII) 阻止或屏蔽,支持自定义正则表达式模式。

- 标准格式概率检测:上下文接地检查,通过源接地检测幻觉,查询相关性验证。

其他功能

与模型无关的实现:

- 与所有

Amazon Bedrock基础模型兼容 - 支持微调模型

- 通过

ApplyGuardrail API扩展到外部自定义和第三方模型

这个全面的框架可帮助客户实施负责任的 AI,在各种生成式 AI 应用程序中维护内容安全和用户隐私。

解决方案概述

护栏配置

- 使用针对您的使用案例量身定制的特定策略创建护栏并配置策略。

与 InvokeModel API 集成 - 使用请求中的护栏标识符调用

Amazon Bedrock InvokeModel API。 - 当您进行

API调用时,Amazon Bedrock会将指定的护栏应用于输入和输出。

护栏评估流程

输入评估:在将提示发送到模型之前,护栏会根据配置的策略评估用户输入。

并行策略检查 :为了改善延迟,将针对每个配置的策略并行评估输入。

输入干预:如果输入违反了任何护栏策略,则返回预配置的阻止消息,并丢弃模型推理。

模型推理:如果输入通过护栏检查,则会向指定模型发送提示进行推理。

输出评估:模型生成响应后,护栏会根据配置的策略评估输出。

输出干预:如果模型响应违反了任何护栏策略,则它将被预配置的消息阻止或屏蔽敏感信息,具体取决于策略。

响应交付:如果输出通过所有护栏检查,则响应将返回给应用程序,而不进行修改

使用Amazon服务实施深度防御策略

虽然 Amazon Bedrock Guardrails 提供了基本内容和及时的安全控制,但在部署任何基础模型时,实施全面的深度防御策略至关重要,尤其是 DeepSeek-R1 等开放权重模型。

主要亮点包括:

- 从安全开始,培养组织弹性

- 使用Amazon服务在安全的云基础上构建

- 跨多个信任边界应用分层防御策略

- 解决LLM应用程序的

OWASP前10大风险 - 在整个

AI/ML生命周期中实施安全最佳实践 - 将Amazon安全服务与

AI和机器学习 (AI/ML) 特定功能结合使用 - 考虑不同的观点并使安全性与业务目标保持一致

- 准备和缓解风险,例如及时注入和数据中毒

评论区